Probé Gemini 3 Pro desde la perspectiva de alguien que diseña y construye aplicaciones y sitios web. La idea fue simple: ver si un modelo puede generar landing pages con personalidad, interacción y —lo más importante— resultados que no se sientan copiados ni genéricos. Aquí comparto lo que aprendí, ejemplos concretos, comparaciones con Gemini 2.5 Pro y pasos prácticos para llevar estas capacidades a tu flujo de trabajo. También dejo los enlaces directos a las herramientas utilizadas para que las pruebes tú mismo: Google AI Studio: https://aistudio.google.com y Gemini: https://gemini.google.com

Tabla de contenidos

- 🧭 Primera impresión: ¿qué trae Gemini 3 Pro?

- ⚖️ Comparativa práctica: Gemini 3 Pro vs Gemini 2.5 Pro

- 💡 Ejemplo completo: Smart Desk Pro — del prompt a la demo

- 🧱 Canvas y exportación HTML: código listo para probar

- 🏛️ Caso de uso: Ventanas Multiverso — una landing con cuatro estilos

- 📚 Mini school: crear plataformas con IA

- 🔧 Buenas prácticas para prompts que generen webs no genéricas

- 🧪 Limitaciones y puntos a mejorar

- 🔁 Integración en tu flujo de trabajo de diseño y desarrollo

- 🧠 Observaciones sobre la «proactividad» del modelo

- 📈 Evolución y perspectivas: ¿hacia dónde va esto?

- 🛠️ Truco rápido: llevar HTML generado a producción

- 🔗 Enlaces útiles

- 🧾 Resumen y recomendaciones finales

- 🚀 Próximos pasos

🧭 Primera impresión: ¿qué trae Gemini 3 Pro?

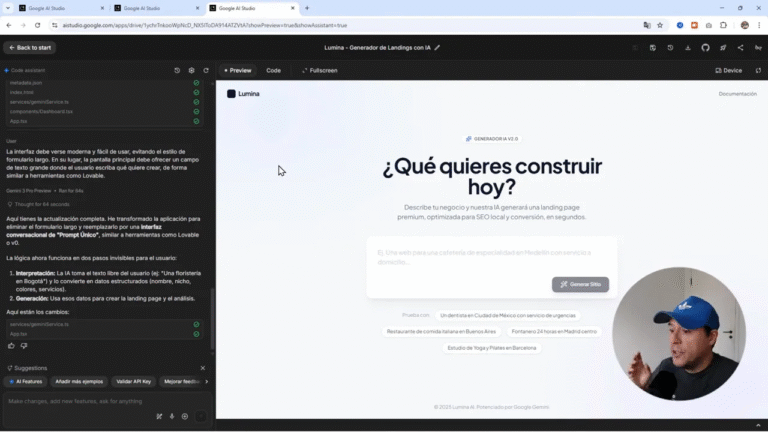

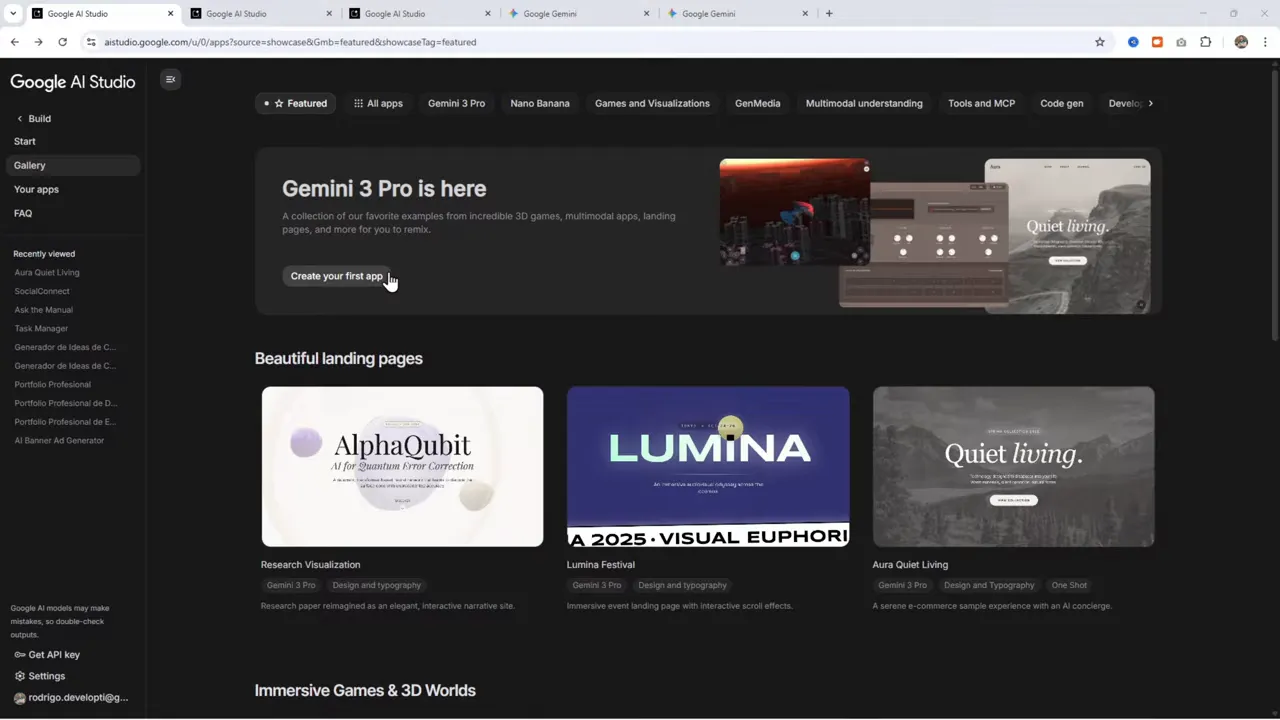

La experiencia inicial con Gemini 3 Pro es distinta a la de modelos previos. En la interfaz de Google AI Studio hay una galería bien curada con landing pages, juegos y prototipos interactivos que funcionan como ejemplos. Esa galería no solo muestra posibilidades, también sirve como guía de diseño.

Al recorrer esos ejemplos se nota que el enfoque fue hacer cosas atractivas y con vida: animaciones, escenas 3D, voxels. No son meras composiciones estáticas; muchas de esas demos son mini aplicaciones React con código exportable. Como diseñador y desarrollador, esto cambia la conversación: ya no es «puedes generar una imagen de producto», es «puedes generar una UI interactiva lista para probar.»

«Claramente se han basado más en poner cosas más relativas, más parecidas a juegos, más que otra cosa. Pero está bien. Están como apuntando a que sea atractivo para todas las personas.»

⚖️ Comparativa práctica: Gemini 3 Pro vs Gemini 2.5 Pro

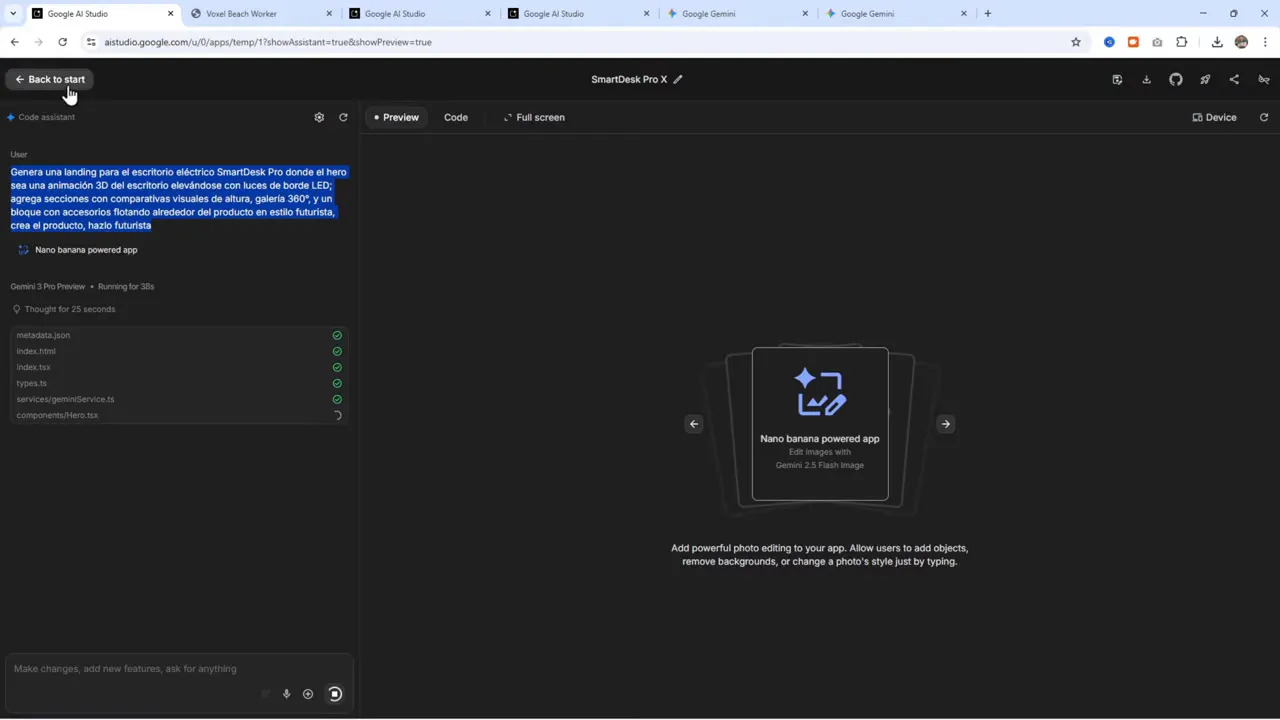

Lo mejor para comparar es replicar un mismo prompt en ambos modelos. Pedí una landing futurista para un escritorio eléctrico llamada Smart Desk Pro pidiendo una animación 3D del escritorio elevándose, luces LED, comparativas de altura, galería 360 y accesorios flotando alrededor.

Resultado con Gemini 3 Pro:

- Generó una mini aplicación con animación funcional y controles.

- Incluyó la visualización del producto con una imagen de ejemplo (utilicé el término «nano banana» como mock image cue).

- La UI tuvo un aspecto moderno y no genérico; la interacción (subir/bajar la mesa) estaba implementada.

Resultado con Gemini 2.5 Pro:

- Entendió parte del prompt pero generó una salida más limitada, enfocada en una sección estática o una demostración incompleta.

- Faltó la cohesión y la interacción que sí aparecieron en Gemini 3 Pro.

Conclusión: para prompts multimodales y con intención de interacción, Gemini 3 Pro ofrece resultados más completos y «con vida». No es magia: en prompts complejos la diferencia se nota al construir la experiencia completa, no solo un diseño estático.

💡 Ejemplo completo: Smart Desk Pro — del prompt a la demo

El prompt que usé fue específico y descriptivo. Algo así funciona mejor que frases vagas:

«Genera una landing page para el escritorio eléctrico Smart Desk Pro donde el giro sea una animación 3D del escritorio elevándose con luces de borde LED. Agrega secciones con comparativas visuales de altura, galería 360 y un bloque con accesorios flotando alrededor del producto en estilo futurista. Crea el producto a lo futurista acorde al team. Usa imagen ‘nano banana’ como placeholder.»

Detalles prácticos que ayudaron a mejorar el resultado:

- Ser específico con la interacción: pedir explícitamente «animación 3D del escritorio elevándose» en lugar de «animación».

- Agregar referencias de estilo: palabras como «futurista», «luces LED», «galería 360» orientan mejor el generador para no producir interfaces genéricas.

- Incluir placeholders: nombres como «nano banana» sirven para que la IA sepa dónde y cómo colocar imágenes de producto.

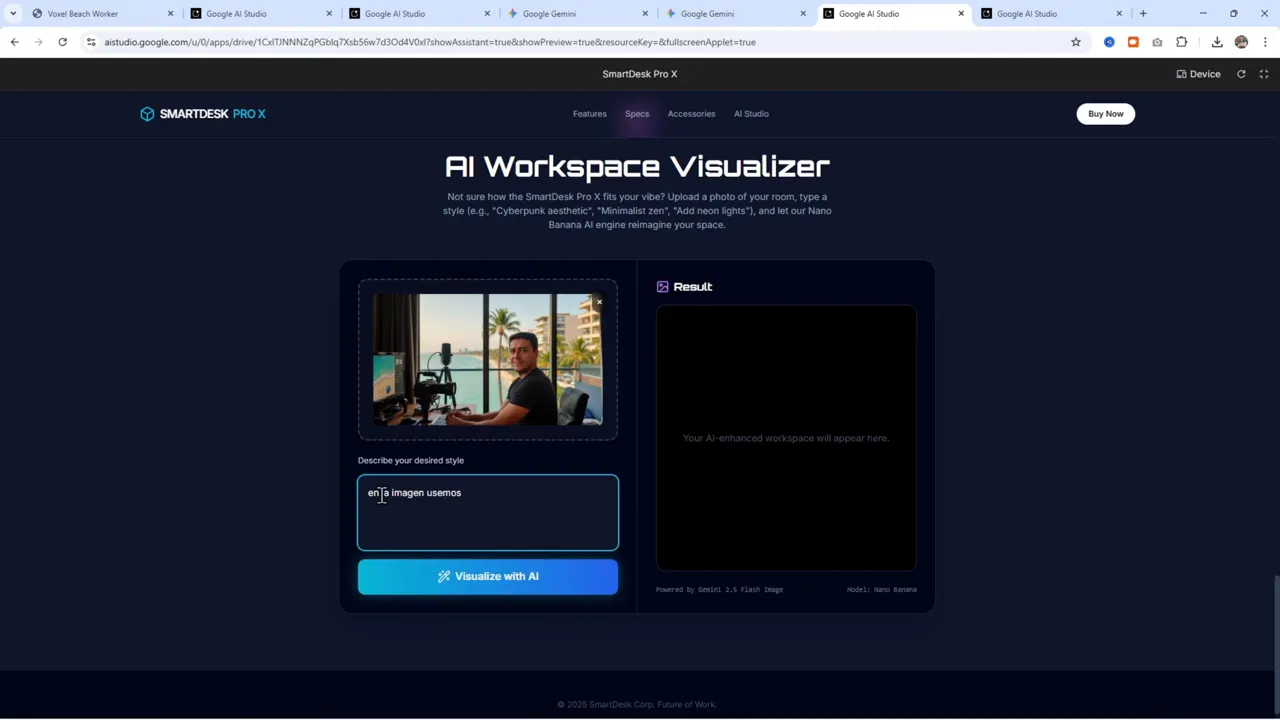

Una vez generado, la demo permitía subir imágenes y ver cómo la pieza se integra en la escena, aunque con pequeñas imperfecciones (por ejemplo, la imagen del producto podía quedar sobre otra mesa si no se ajustaba el prompt de colocación). Aun así, el flujo está ahí: prompt → build → preview → exportar.

🧱 Canvas y exportación HTML: código listo para probar

Además de la galería de ejemplos, la herramienta incluye un modo Canvas pensado para generar HTML directamente. Eso es ideal cuando quieres resultados rápidos y exportables sin convertir un proyecto React completo.

Ventajas del modo Canvas:

- Genera código HTML que se puede copiar, pegar y ejecutar en un simple archivo .html.

- Ofrece vista previa en vivo y permite descargar el paquete completo.

- Funciona con la versión gratuita de Gemini en la aplicación de Gemini, lo que facilita iterar sin montar un entorno complejo.

Consejo práctico: cuando obtengas el HTML, abre el Bloc de notas o cualquier editor de texto, pega el código y guarda como ejemplo.html. Abre el archivo en el navegador y tendrás la demo localmente. Esto es excelente para prototipado rápido o pruebas con clientes.

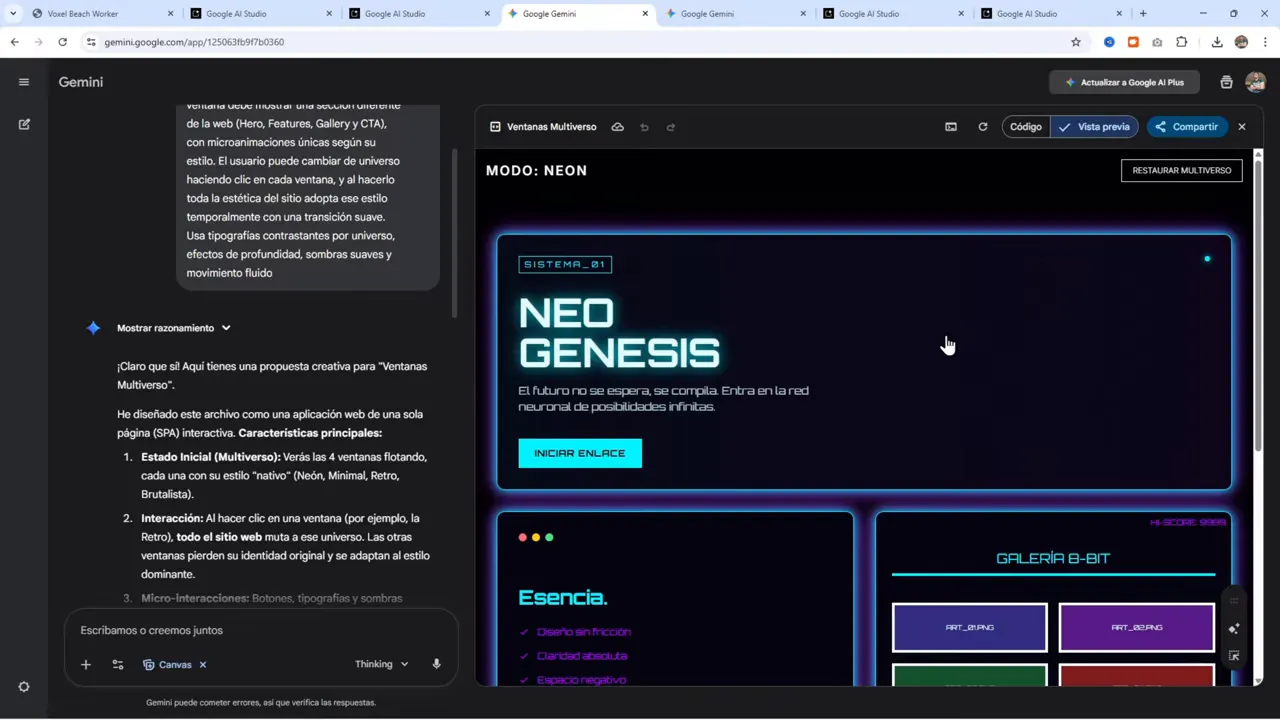

🏛️ Caso de uso: Ventanas Multiverso — una landing con cuatro estilos

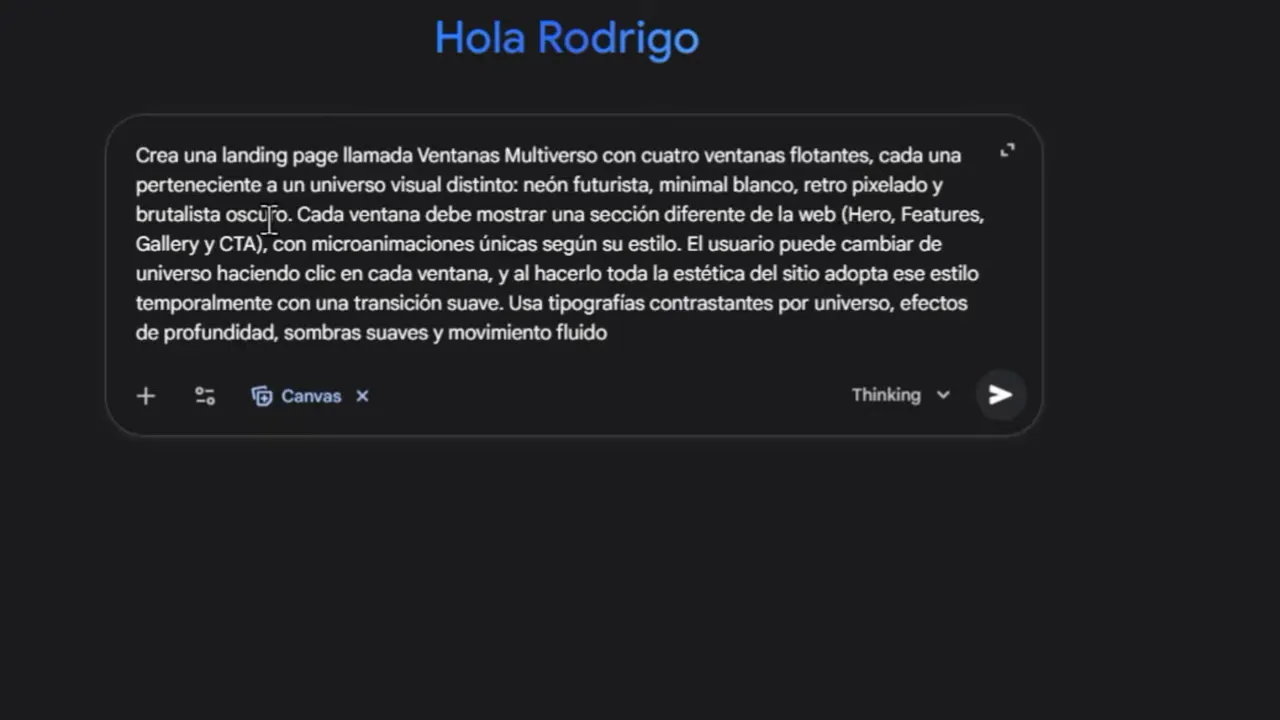

Uno de los prompts más interesantes fue pedir una landing llamada Ventanas Multiverso con cuatro ventanas flotantes, cada una representando un universo visual distinto: neon futurista, minimal blanco, retropixelado y brutalista oscuro. La idea era ver si la IA puede adaptar la misma estructura a estilos visuales radicalmente distintos.

Resultado:

- La landing se generó con interacciones para cambiar entre modos visuales.

- Cada ventana mostró un estilo coherente con la descripción: 8 bits para retropixelado, minimal con tipografía limpia para minimal, etc.

- La animación y la respuesta visual fueron fluidas: la página «cobró vida» al cambiar estilos, algo que modelos anteriores tenían dificultad en lograr.

Este tipo de generación es ideal para pruebas A/B o para mostrar variantes de estilo a clientes en segundos. En vez de hacer múltiples comp, pides las variantes y obtienes prototipos navegables.

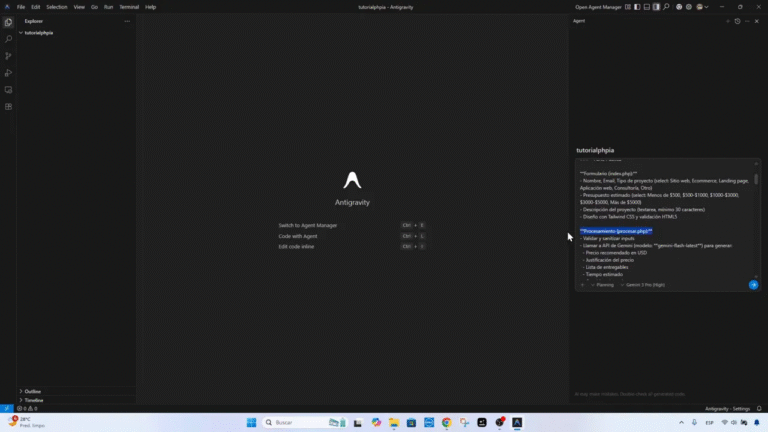

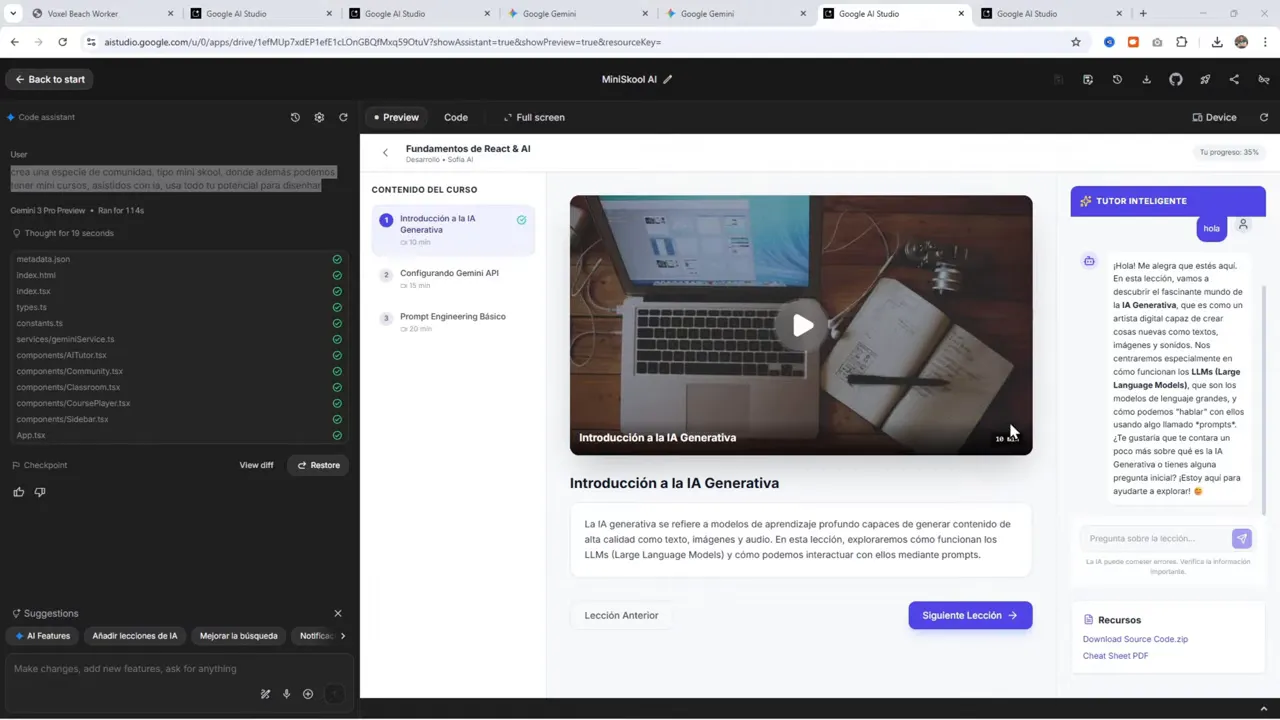

📚 Mini school: crear plataformas con IA

Uno de los experimentos más sorprendentes fue generar una mini plataforma de cursos o «mini school». Con un prompt corto pedí una comunidad tipo mini school donde se ofrezcan mini cursos asistidos por IA. Lo que apareció fue más que una página: la IA generó un esquema de aula virtual con lecciones, un tutor inteligente y tracking de progreso.

Elementos que surgieron automáticamente:

- Lista de lecciones con progreso.

- Un tutor o asistente IA «integrado» en la interfaz para guiar al usuario.

- Un botón de «nuevo post» y flujo básico de creación de contenido (aunque como demo, algunos botones no estaban enlazados por defecto).

Acción práctica: pedí que el botón de «nuevo post» funcionara y la IA generó la lógica para crear y publicar contenido. No es un backend completo, pero sí una base funcional para construir sobre una app real.

🔧 Buenas prácticas para prompts que generen webs no genéricas

Generar resultados con personalidad depende en gran medida del prompt. Aquí tienes un checklist basado en lo que funcionó:

- Describe la interacción, no solo la apariencia. Si quieres animaciones o estados, pídelo explícitamente.

- Usa referencias de estilo concretas. «Neon futurista», «retropixelado 8 bits», «brutalista oscuro» ayudan a evitar salidas neutras.

- Incluye ejemplos o placeholders para imágenes. Un cue como «nano banana» sirve para que la IA coloque una imagen contextual.

- Solicita la exportación en el formato que necesitas. «Genera código HTML exportable» o «crea una app React» guía la salida técnica.

- Pide modularidad. Solicita secciones independientes y componentes reutilizables para facilitar iteraciones.

- Itera sobre el resultado. Pide cambios puntuales: «haz más contraste en la hero» o «reduce el tamaño del CTA».

🧪 Limitaciones y puntos a mejorar

Gemini 3 Pro no es perfecto. Algunos detalles a considerar antes de integrarlo completamente en producción:

- Precisión espacial: a veces coloca imágenes encima de elementos erróneos o necesita instrucciones más claras sobre posicionamiento.

- Comportamiento dinámico: no todos los botones funcionarán fuera del entorno generado; a veces falta el backend o rutas reales.

- Usabilidad de la interfaz de generación: hay una tendencia a enfatizar la galería de ejemplos sobre la simplicidad de uso para prompts complejos; puede ser más difícil encontrar dónde pegar prompts largos.

- Control fino de estilos: para ajustes tipográficos o microinteracciones muy específicos, aún conviene hacer retoques manuales después de la generación.

«No me gustó nada el resultado versus el de Gemini 3 acá. Ok, entonces quedémonos acá porque me gustó el resultado.»

Esa ambivalencia refleja el estado actual: el modelo avanza rápidamente, pero aún requiere supervisión humana para pulir detalles y garantizar consistencia.

🔁 Integración en tu flujo de trabajo de diseño y desarrollo

Cómo aprovecharlo en proyectos reales:

- Prototipado rápido: genera variantes visuales para validar dirección antes de desarrollar componentes.

- Presentaciones a clientes: crea demos interactivas en minutos para comunicar ideas de producto.

- Generación de assets: usa placeholders y pide versiones adaptadas para distintos tamaños y resoluciones.

- Base para sprints de desarrollo: exporta HTML desde Canvas y conviértelo en componentes React si necesitas ampliar funcionalidad.

Además, el hecho de que el modelo exporte código HTML simplifica el paso de prototipo a prueba de concepto: menos tiempo en traducir visuales a código y más tiempo en lógica de negocio.

🧠 Observaciones sobre la «proactividad» del modelo

Una de las cosas más llamativas es la proactividad: la capacidad del modelo para añadir elementos coherentes que no se pidieron explícitamente. En la mini school, por ejemplo, generó el esquema de lecciones, el tutor y el tracker de progreso sin solicitarlo.

La proactividad es útil, pero exige cuidado. Si bien puede acelerar el trabajo, también puede introducir supuestos que no encajan con la visión del producto. Por eso es clave pedir iteraciones y validaciones explícitas:

- Pide al modelo que documente qué supuestos tomó.

- Revisa y solicita correcciones puntuales sobre esos supuestos.

- Usa la proactividad como sugerencia, no como decisión final.

📈 Evolución y perspectivas: ¿hacia dónde va esto?

El salto entre versiones muestra una tendencia clara: modelos cada vez más capaces de generar experiencias completas, no solo assets aislados. Estamos pasando de «generar imágenes» a «generar aplicaciones interactivas». Esto tiene implicaciones en:

- Velocidad de prototipado: menor tiempo para validar ideas.

- Accesibilidad del diseño: más personas pueden crear prototipos sin dominar front-end.

- Democratización del producto: equipos pequeños pueden avanzar más rápido con menos recursos.

Es razonable esperar que en las próximas versiones se mejore la estabilidad del código generado, la integración con backends y el control fino de microinteracciones.

🛠️ Truco rápido: llevar HTML generado a producción

Si obtienes una exportación HTML desde Canvas y quieres usarla como base, sigue estos pasos:

- Copia el HTML en un archivo ejemplo.html y ábrelo en el navegador para revisar comportamiento visual.

- Identifica componentes reutilizables (hero, gallery, product module) y extráelos a archivos separados.

- Convierte esos bloques a componentes React si necesitas estados o integración con APIs.

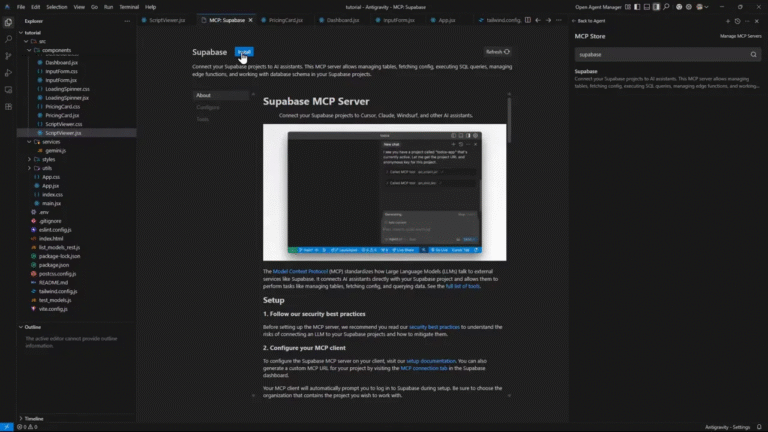

- Agrega un backend ligero (Firebase, Supabase) para manejar formularios, comentarios o tracking de progreso.

- Revisa accesibilidad y performance: fuentes, carga de imágenes y animaciones afectan el SEO y la usabilidad.

🔗 Enlaces útiles

Herramientas mencionadas y enlaces directos:

- Google AI Studio: https://aistudio.google.com

- Gemini: https://gemini.google.com

🧾 Resumen y recomendaciones finales

Gemini 3 Pro marca un paso adelante en la generación de experiencias web. Las mejoras frente a 2.5 Pro son notorias cuando se piden interacciones y páginas con vida. Sus puntos fuertes son la capacidad multimodal, la proactividad y la exportación directa a HTML o pequeñas aplicaciones. Sus limitaciones aún obligan a revisión humana y ajustes para ambientes de producción.

Si trabajas en diseño, producto o desarrollo, te recomiendo:

- Empezar con prompts muy específicos sobre interacción y estilo.

- Usar Canvas para prototipos rápidos y exportación de código.

- Iterar constantemente y usar la proactividad del modelo como punto de partida.

La dirección es clara: herramientas cada vez más capaces para generar productos digitales completos. Con un enfoque crítico y procesos de validación, estas IAs son ahora aliadas reales para acelerar la creación y experimentar con ideas sin invertir semanas en maquetado inicial.

🚀 Próximos pasos

Experimenta con prompts que definan microinteracciones y pide variantes de estilo para ver cuánta coherencia mantiene el modelo. Prueba integrar los HTML exportados en prototipos reales y añade un backend mínimo para validar flujos de usuario. Y mantén notas sobre los supuestos que la IA introduce en cada generación para poder revisarlos en la siguiente iteración.